本地化

本地化大模型

如何将大模型在本地计算机、服务器部署?这里所说的“大模型”指开源大预言模型(LLMs)。

本地大模型知识库工具|

大模型本地化需要的工具(20040805):

1、Ollama,开源免费的用于将大模型本地化部署及运行的工具;有了它可以轻松实现“一句代码部署”;

2、Open WebUI,开源免费的大模型网页界面工具;有了它可以将Ollama部署的大预言模型方便的通过网页交互使用及管理模型;

3、Anyting LLM,构建本地知识库的工具;有了它可以完善大模型的知识库;

简单来说,以上是大模型本地化的“三剑客”工具:用Ollama安装模型、用Open WebUI使用模型、用Anything LLM完善模型。

问题:如何部署安装|Ollama模型地址|

# Huggingface下载

export HF_ENDPOINT=https://hf-mirror.com

huggingface-cli download Qwen/Qwen2-7B-Instruct-GGUF qwen2-7b-instruct-q5_k_m.gguf --local-dir /root/models/

# git下载模型

进入modelscope,查询Qwen2-0.5B,进入对应的主页,点击页面靠近上方的“模型文件”,点击右侧紫色“下载模型”,弹出窗口显示下载方法:

git clone https://www.modelscope.cn/qwen/Qwen2-0.5B.git

或者使用ModelScope安装(注意其下载位置在缓存目录中:~/.cache/modelscope):modelscope download --model qwen/Qwen2-0.5B

#使用环境变量指定路径

export MODELSCOPE_CACHE=/byp/AI/LLMs

# GGUF连接

#首先需要安装llama-cpp-python

apt update

apt install build-essential cmake

pip install --upgrade pip setuptools wheel

#conda安装成功

conda install -c conda-forge llama-cpp-python

#升级

pip install --upgrade llama-cpp-python

#可以执行以下命令:

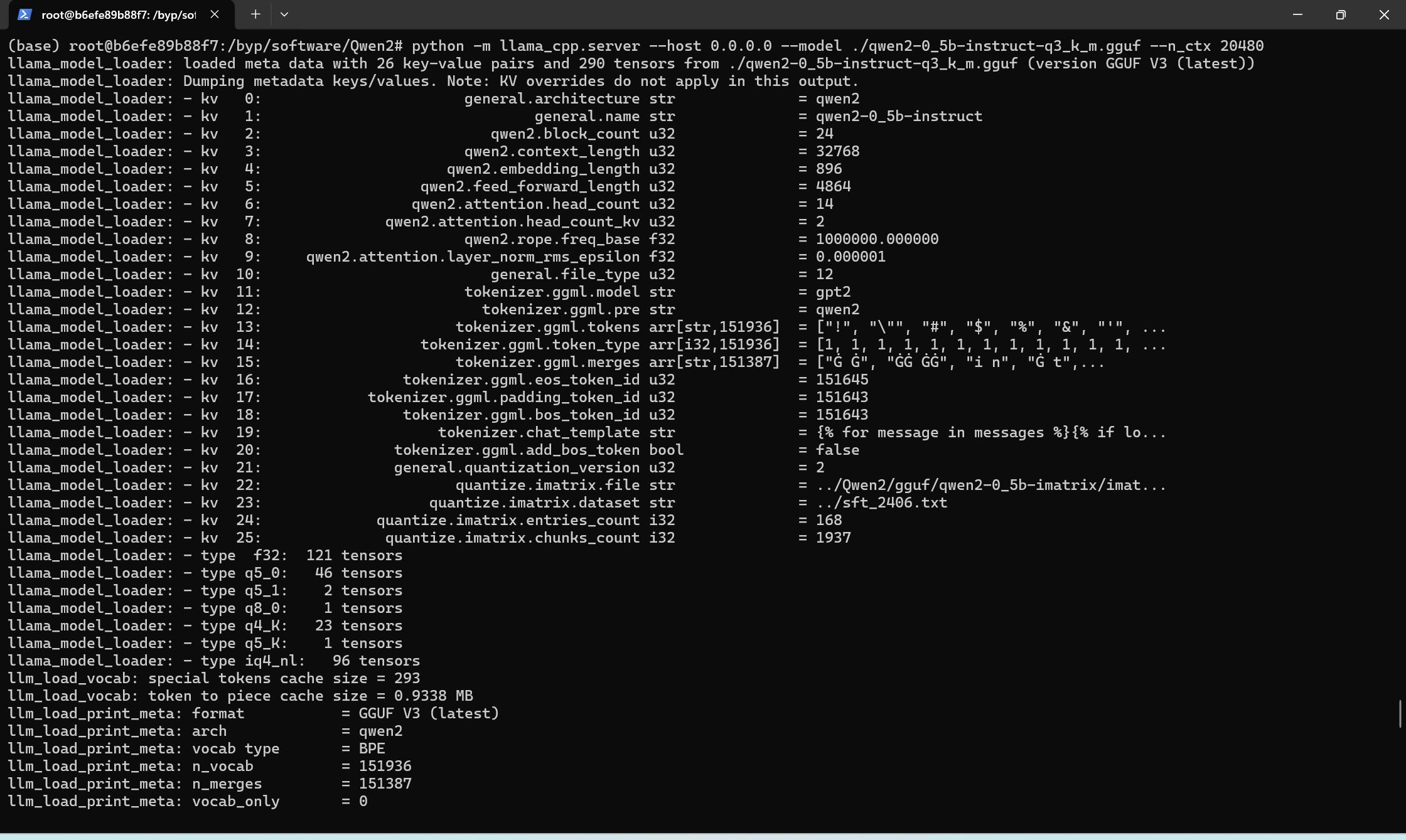

python -m llama_cpp.server --host 0.0.0.0 --model ./qwen2-0_5b-instruct-q3_k_m.gguf --n_ctx 20480

GGUF下载地址:Qwen2-7B-Instruct-GGUF|Qwen2-0.5B-Instruct-GGUF|Qwen2-1.5B-Instruct-GGUF|

千问2(Qwen-2)的模型仓库中提供了多种不同版本的模型格式,主要包括 FP16 模型和各种量化(Quantized)模型格式,如 q5_0、q5_k_m、q6_k、q8_0 等。这些不同版本的模型之间存在一些重要区别,它们的多样性是为了满足不同的硬件要求和使用场景。以下是这些版本的详细解释:

### 1. **FP16 模型**

- **FP16(半精度浮点数)**:这种模型使用 16 位浮点数来表示数据,相比于 32 位浮点数(FP32),它减少了内存占用和计算量,同时保留了相对较高的模型精度。

- **用途**:FP16 模型适用于支持半精度计算的硬件,如 NVIDIA 的 Tensor Cores,可以在不显著降低精度的情况下大幅提高推理速度和降低内存使用。

### 2. **量化模型**

- 量化模型通过使用更低位的整数来表示模型参数,以减少模型的大小和计算需求。通常在精度和计算效率之间进行权衡。以下是几种常见的量化格式:

- **q5_0**

- **表示**:使用 5 位量化的简单方法。

- **特点**:相比更高位数的量化方法,模型体积更小,但可能会有更大的精度损失。

- **用途**:适用于内存非常有限的场景,但对模型精度要求不高的应用。

- **q5_k_m**

- **表示**:一种改进的 5 位量化方法,通常结合某种优化技巧(如乘性量化),以减少精度损失。

- **特点**:在保证小模型体积的同时,提供比 q5_0 更高的精度。

- **用途**:适合在对内存占用有严格要求,但希望保留较高精度的场景下使用。

- **q6_k**

- **表示**:使用 6 位量化,通常结合类似 k-means 或其他优化算法以减少精度损失。

- **特点**:相比 5 位量化,提供了更好的精度,模型大小介于 5 位和 8 位量化之间。

- **用途**:适用于希望在模型大小和精度之间取得平衡的场景。

- **q8_0**

- **表示**:使用 8 位量化,通常是量化精度较高的一种方法。

- **特点**:在所有量化方法中,q8_0 提供了最接近原始 FP16 模型的精度,同时大幅减少了模型的体积。

- **用途**:适用于对精度要求较高,同时希望降低计算和内存需求的场景。

### 3. **为什么分这么多版本?**

- **硬件兼容性**:不同硬件设备的计算能力和内存大小各不相同。通过提供不同版本的模型,可以针对性地优化模型在不同硬件上的运行效率。

- **计算资源优化**:某些任务可能更关注计算速度或内存占用,而不需要最高的精度。量化模型可以大幅减少计算需求,适用于推理速度至关重要的场景。

- **模型部署**:在边缘设备或移动设备上,计算资源和内存有限,使用更小的量化模型可以实现更高效的部署。

### 总结

FP16 模型适用于对精度要求高的场景,而量化模型则是在精度和资源之间进行权衡的产物,提供了更广泛的适应性以满足各种实际应用需求。根据具体的使用场景和硬件条件,选择合适的模型版本可以显著提升模型的效率和效果。