LLMs

LLMs

本地化 | RAG | FineTuning | Huggingface/eebyp | groq | prompt | 向量

Llama3.1据说在1.6万张英伟达H100的GPU训练了几个月,花了几亿美金,消耗的电量都能够给一个小国家供电了。不过Meta对中国并不友好(图1|图2)。

本地大模型知识库工具

AnythingLLM、MaxKB、RAGFlow、FastGPT、Dify 、 Open WebUI 、Ollama

Agent:COZE、Dify、AUTOGEN STUDIO(微软),METAGPT、phidata、AutoGen,LangChain

Anything LLM、Open WebUI、MaxKB、RAGFlow、FastGPT( 海小星| 海小星Ⅰ(微调7B-Q4)| 海小星Ⅱ(微调7B-F16))、Dify(海小星)等开展相关研究开发,并开通的本地大模型应用系统(海小星)。

LLM可视化介绍:Transformer(截图|论文|GitHub)、LLM(英文、中文)

LLM斗兽场:OpenRouter(截图|地址)|Groq(截图|地址)

大模型在设计上均分为Base模型和Instruct模型,而不再沿用之前的Chat模型的说法:

1. Base模型:

• Base模型通常指的是未经特定指令微调的通用型预训练模型。这类模型经过大规模文本数据的训练,能够理解和生成自然语言,但没有针对特定任务进行过细调。因此,Base模型更加通用,可以应用于各种自然语言处理任务,如文本生成、语义理解等,但可能需要用户根据具体应用场景进一步微调或适配。

2. Instruct模型:

• Instruct模型则是经过指令理解(Instruction Tuning)微调的版本,这意味着模型被进一步训练以更好地理解并执行人类提供的指令。这类模型在处理有明确指令指导的任务时表现出色,比如问答、信息检索、代码生成等。Instruct模型通过学习如何遵循人类指令,提升了模型在执行特定类型任务时的准确性和流畅性。(来源)

Qwen2:github.io(英文/中文)|github.com|Demo(HF)|HF|

运行Qwen2-mainexamplesdemo出现libiomp5md.dll报错及解决|

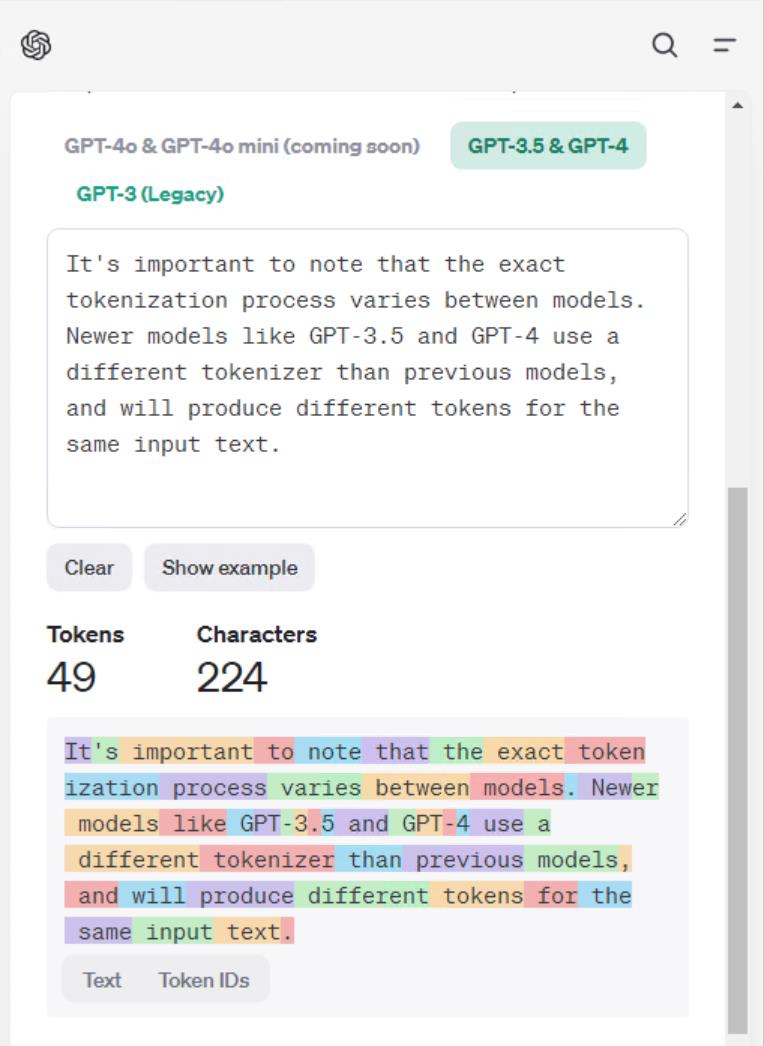

Tokenizer

Learn about language model tokenization

OpenAI's large language models (sometimes referred to as GPT's) process text using tokens, which are common sequences of characters found in a set of text. The models learn to understand the statistical relationships between these tokens, and excel at producing the next token in a sequence of tokens.

You can use the tool below to understand how a piece of text might be tokenized by a language model, and the total count of tokens in that piece of text.

It's important to note that the exact tokenization process varies between models. Newer models like GPT-3.5 and GPT-4 use a different tokenizer than previous models, and will produce different tokens for the same input text.

参考:

BERT vs ERNIE: The Natural Language Processing Revolution

一文详解 BERT 与 ERNIE 有何不同?

List of the Best 21 Large Language Models (LLMs) (August 2024)

2024 AI Index Report

hiyouga/LLaMA-Factory

WangRongsheng/awesome-LLM-resourses

可视化介绍LLM

微调BERT实现中文微博情感分类

LLM学习路径

LLaMA 3 掀桌子三部曲(二):LLaMA 3.1 发布

基于社会感知的城市洪涝位置提取与语义计算